Il serait bien de mettre un titre à votre page, et de faire une petite phrase d'introduction pour expliquer “pourquoi vous traitez de ce sujet”.

Le vocabulaire “miner du bitcoin” nécessite un éclaircissement.

La structure est un peu confuse (images pas forcément bien placées sur la première partie)

Il faudrait utiliser les niveaux de titre du Wiki pour obtenir un sommaire

Il y a du français à corriger

Des processeurs TPU et ASIC

Présentation des deux types de processeurs avec leurs caractéristiques et explications sur leurs utilisations.

1) ASIC

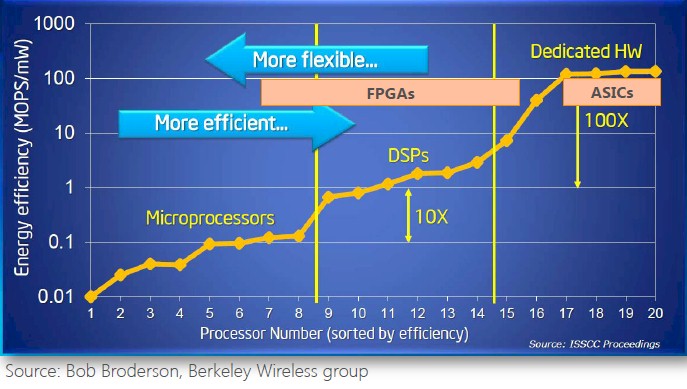

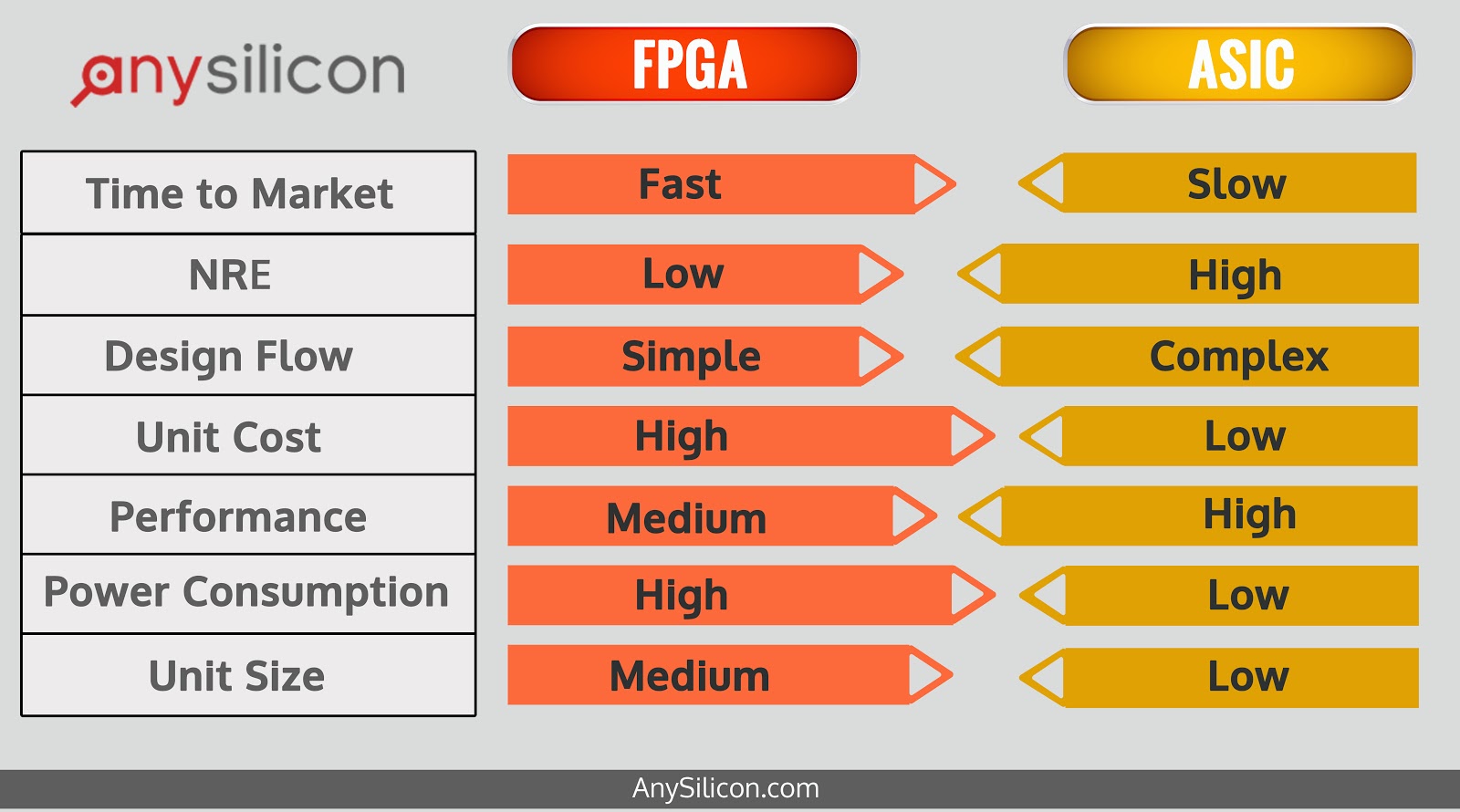

Signifie acronyme de l'anglais application-specific integrated circuit, littéralement « circuit intégré propre à une application ». Ce type de circuit intégré n’est pas flexible avec les applicatifs. Il est configuré pour gérer une seul tache bien précise. Le coup de ce composant est faible et il est très performant. Beaucoup d’ASICs sont actuellement utilisés pour miner du bitcoin (crypto-monnaie) car elles sont puissantes et elles sont les seules à miner efficacement grâce à leur efficacité.

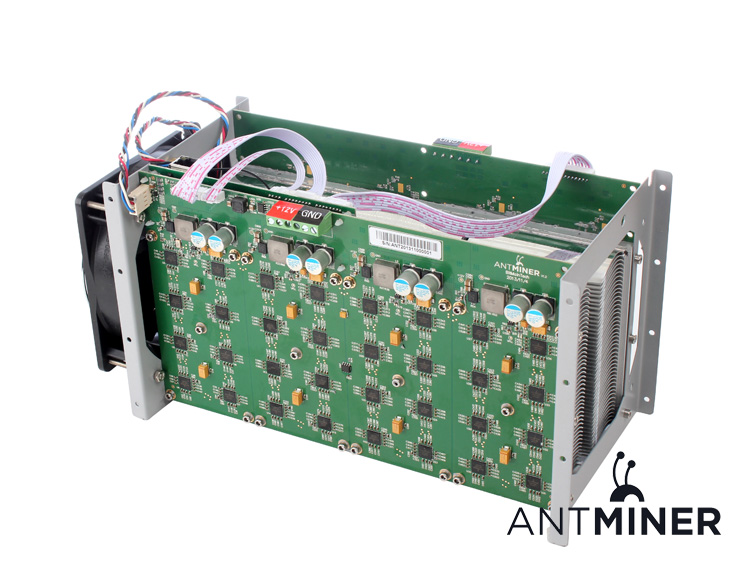

Mineur de bitcoin

Mineur est le terme employé pour les personnes qui collectent de la crypto-monnaie, qui réalise des transactions entre particuliers. Les mineurs de monnaie minent leur monnaie cryptographique dans leurs fermes, des ordinateurs spécialement qui se dédient à cette tâche. Ces personnes sont rémunérées pour ce minage.

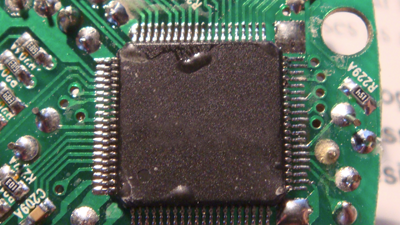

Puce ASIC

Les processeurs ASIC, comme montrés ci dessus, sont plus performants car ils sont utilisés pour la réalisation d’une tâche précise dans laquelle ils sont spécialisés et ne savent rien faire d’autre.

2) TPU

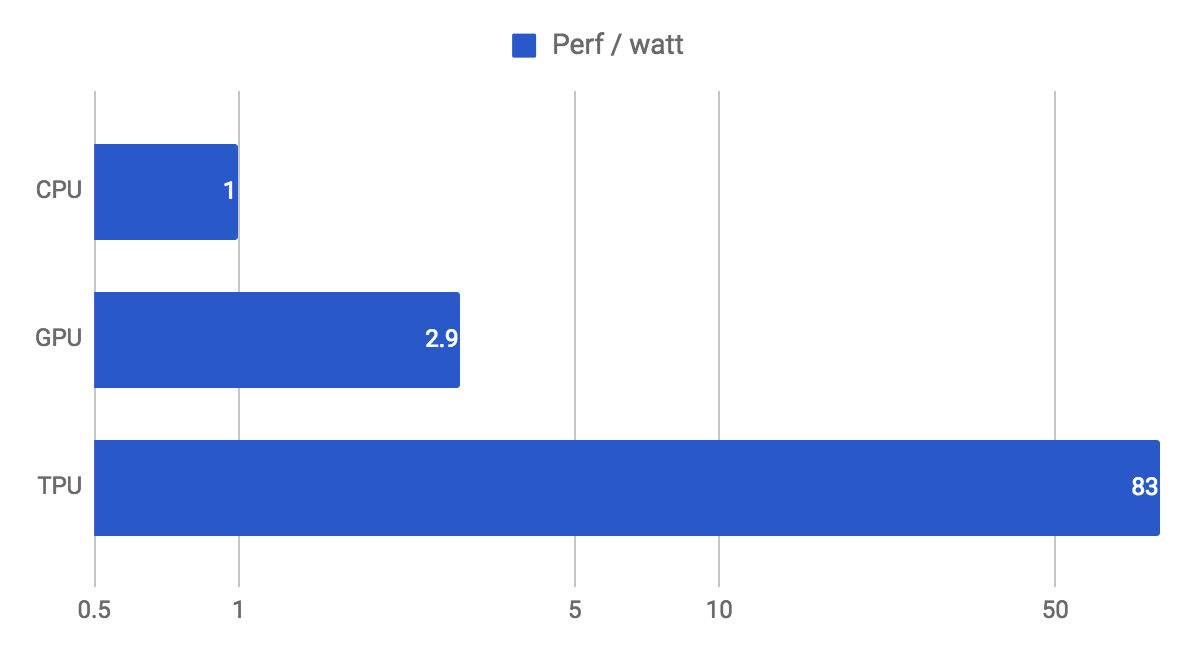

TPU signifie “Tensor Processing Unit” et permet d'accélérer la vitesse d’apprentissage des intelligences artificielles, ce sont des machines ASIC spécialisées dans le machine learning avec réseaux neuronaux. Les TPU sont aussi appelés accélérateur d'intelligence artificielle. Ils sont 15 à 30 fois plus efficaces que des processeur ou GPU standard dans le domaine du machine learning et consomment beaucoup moins d’électricité par rapport à leurs performances.

Google s’est rendu compte que la taille du nombre de serveur allait doubler pour la recherche sur les intelligences artificielles, ils se sont rendu compte que cela n'allait pas être possible à cause de coûts trop élevés. Ils ont donc décidé de créer les TPU qui sont beaucoup plus efficaces au rapport efficacité/prix. Ils ont réussi à designer et créer cette puce en 15 mois.

Google a décidé de l’appeler “accélérateur d’intelligence artificielle” (“Tensor Processing Unit”) car leur librairie open source pour le machine learning s'appelle “Tensorflow”

Google n’a pas donné beaucoup de détails sur l’architecture de sa puce. Nous savons qu’elles sont basés sur une lithographie a 28nm, elle marche a 700MHz et consomme seulement 40W. Les TPU sont connectés à un hôte via PCIe Gen3 x16, ce qui lui donne une bande passante effective de 12.5GB/s. Il faut des processeurs spéciaux comme les TPU pour les réseaux neuronaux car ceux-ci requiert un grand nombre de calcul (des réseaux neuronaux standards peuvent avoir 140 millions de paramètres). Il est actuellement impossible d’acheter de TPU mais il y a possibilité de les louer dans le cloud, cela reste un outil utilisé dans un domaine très professionnel. Google a récemment donné 1000 TPU à des chercheurs pour accélérer la recherche dans ce domaine.

Les intelligences artificielles ne peuvent pas utiliser efficacement les CPU car ceux-ci ne peuvent seulement faire qu’une opération a la fois contrairement aux GPU qui peuvent faire plusieurs calculs en parallèle grâce à plusieurs milliers de cœurs. Les TPU qui sont des machines ASIC spécialisés dans le machine learning sont plus efficaces que les GPU car elles sont spécialisées dans une tache spécifique.

Sources:

https://cloud.google.com/blog/big-data/2017/05/an-in-depth-look-at-googles-first-tensor-processing-unit-tpu https://www.analyticsvidhya.com/blog/2017/05/gpus-necessary-for-deep-learning/ https://drive.google.com/file/d/0Bx4hafXDDq2EMzRNcy1vSUxtcEk/view https://cloud.google.com/blog/big-data/2017/05/an-in-depth-look-at-googles-first-tensor-processing-unit-tpu https://fr.wikipedia.org/wiki/Application-specific_integrated_circuit